Lately I’ve been testing some of the X++ features we can use to extend the Finance and Operations agent in Copilot Studio. One of these features is the X++ AI tools (formerly called AI plugins), which allow us to create Copilot Studio tools that call X++ business logic. Today’s post is a product of my lack of focus and my superpower of ignoring yellow notifications on PPAC. Also, thanks to Jared Hall for the hint…

Part 3 of the Copilot Studio + F&O extensibility series. Learn what client plugins are, when to use them, and how to build one in X++—from action scopes and parameters to implementing executeAction and wiring trigger/response topics. Includes a PurchTable example to confirm POs from the sidecar chat. Click here to continue reading Create X++ Client Plugins for Copilot Studio in Dynamics 365 F&O

Learn how to wire real F&O business logic into Copilot Studio. This guide shows you how to build an X++ AI tool, set up security, auto/hand-register the Dataverse Custom API, configure inputs (including company context), create a topic, publish, and test—end to end. Click here to continue reading Build an X++ AI Tool for Copilot Studio in Dynamics 365 F&O

Kick off a hands-on series on Copilot Studio for Dynamics 365 F&O. See what it is, the setup you need, how it uses Dataverse, built-in copilots, and two X++ extensibility paths: client plugins and AI tools. Click here to continue reading Copilot Studio 101: Extend Dynamics 365 F&O Copilots

Today I’m announcing the first part of the new Dynamics 365 ALM guide for Finance and Operations (F&O) is now…

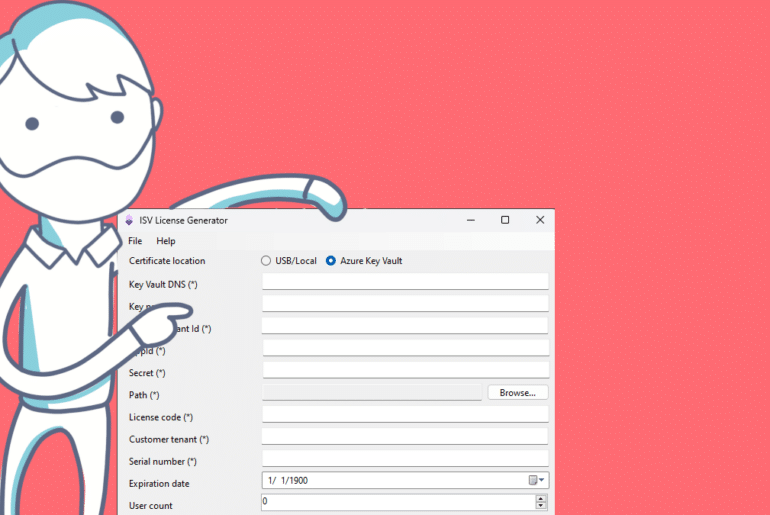

I’ve been working on the ISVLicenseGenerator open source tool for some years now, almost five. It all started when I…

In this post, I’m going to talk about APIOps, the DevOps techniques applied to Azure API Management, that allow us…

A short one for today! I stumbled upon this while configuring the new Azure Synapse Link for Dataverse feature for…