Hoy vengo con un post sobre Dynamics 365 F&O, pero con el foco principal en la seguridad, concretamente en Microsoft Sentinel. Hace unos días se anunció que se había publicado una solución de Microsoft Sentinel para F&O que actualmente está en preview. ¡Vamos a aprender un poco sobre ella!

A veces pasamos por alto los aspectos de seguridad de las cosas que no están directamente relacionadas con F&O, especialmente en lo que se refiere a recursos como redes, cuentas de almacenamiento, máquinas de desarrollo, Microsoft Entra ID (¡este es el nuevo nombre de Azure AD!) o el uso de Bastion.

Y lo hacemos no porque no nos preocupe la seguridad, sino porque somos gente de Dynamics 365, y a veces puede que nos falten conocimientos en otras cosas. Si tienes suerte, contarás con un equipo de seguridad interno que se encargará de eso, si no, tendremos que aprender un poco.

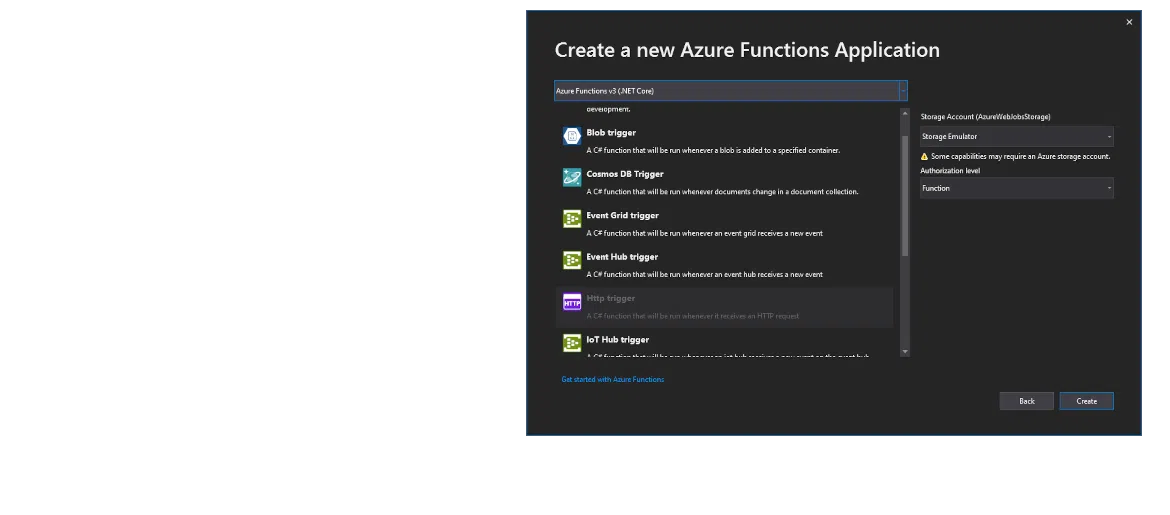

Es la primera vez que uso Microsoft Sentinel, y seguro que me estoy perdiendo muchas cosas y funciones. Es hora de aprender.